- Med den nyeste AI-teknologi er det blevet nemt at generere realistiske billeder af begivenheder, der aldrig har fundet sted

- Men detaljer i billederne kan afsløre, at de ikke er ægte

- Læs med her og få tips til, hvordan du selv kan spotte falske AI-billeder

Trump i en voldsom anholdelse, fredsforhandlinger mellem Putin og en række verdensledere og en eksplosion nær Pentagon-bygningen i USA. Opsigtsvækkende scener, som aldrig har fundet sted, men som med den nyeste billedteknologi inden for kunstig intelligens – populært kaldet AI – konstrueres på ganske realistisk vis.

Det er ikke længere nødvendigt at besidde overmenneskelige evner i Photoshop for at overbevise andre om, at fabrikerede billeder er ægte.

Potentialet for spredning af mis-, des- og malinformation ved hjælp af de hyperrealistiske AI-billeder kan være stort, hvis ikke brugere på sociale medier er varsomme

For AI-værktøjer som Midjourney og Dall-E kan efterhånden generere uhyggeligt virkelighedstro billeder på få sekunder og er samtidig blevet nemmere for almindelige mennesker at bruge.

Og selvom de fleste måske nøjes med at bruge værktøjerne til at genere billeder af katte og fiktive figurer, så bruges AI også – både for sjov og i alvor – til at vise ægte personer, ofte politikere, i mærkværdige situationer.

Potentialet for spredning af mis-, des- og malinformation ved hjælp af de hyperrealistiske AI-billeder kan være stort, hvis ikke brugere på sociale medier er varsomme, advarer internationalt anerkendte faktatjekkere.

For nylig blev en konsekvens af desinformation ved hjælp af AI tydelig, da et falsk billede af en eksplosion nær Pentagon i Washington D.C. fik det amerikanske marked til at tage et kortvarigt dyk.

Men heldigvis er der gode råd at hente. Flere fejl og finurligheder kan nemlig afsløre, om et billede er genereret af AI.

Gå tilbage til kilden

Et godt sted at starte er ofte at bruge omvendt billedsøgning til at finde frem til billedets oprindelige kilde.

Med en omvendt billedsøgning kan du nemlig søge efter et specifikt billede og finde ud af, om det optræder andre steder på internettet – og hvor det i så fald kan findes.

Der findes forskellige programmer til det formål – blandt de mest populære er Google Images og Google Lens, der trawler internettet ved hjælp af Googles søgemaskine, mens programmet TinEye kan sortere billederne efter, hvornår de først blev lagt på internettet

På den måde kan du finde frem til, hvilken sammenhæng billedet optrådte i, da det første gang blev lagt online. Det kan for eksempel være, at den oprindelige kilde til billedet gør tydeligt opmærksom på, at det er genereret ved hjælp af et AI-værktøj.

Selv hvis det ikke direkte står skrevet, at billedet er lavet af AI, så kan en omvendt billedsøgning alligevel være nyttig. For eksempel til at finde lignende billeder, som det falske billede kan være genereret ud fra. Eller billeder i en højere opløsning, hvor AI’ens fejl er lettere at få øje på.

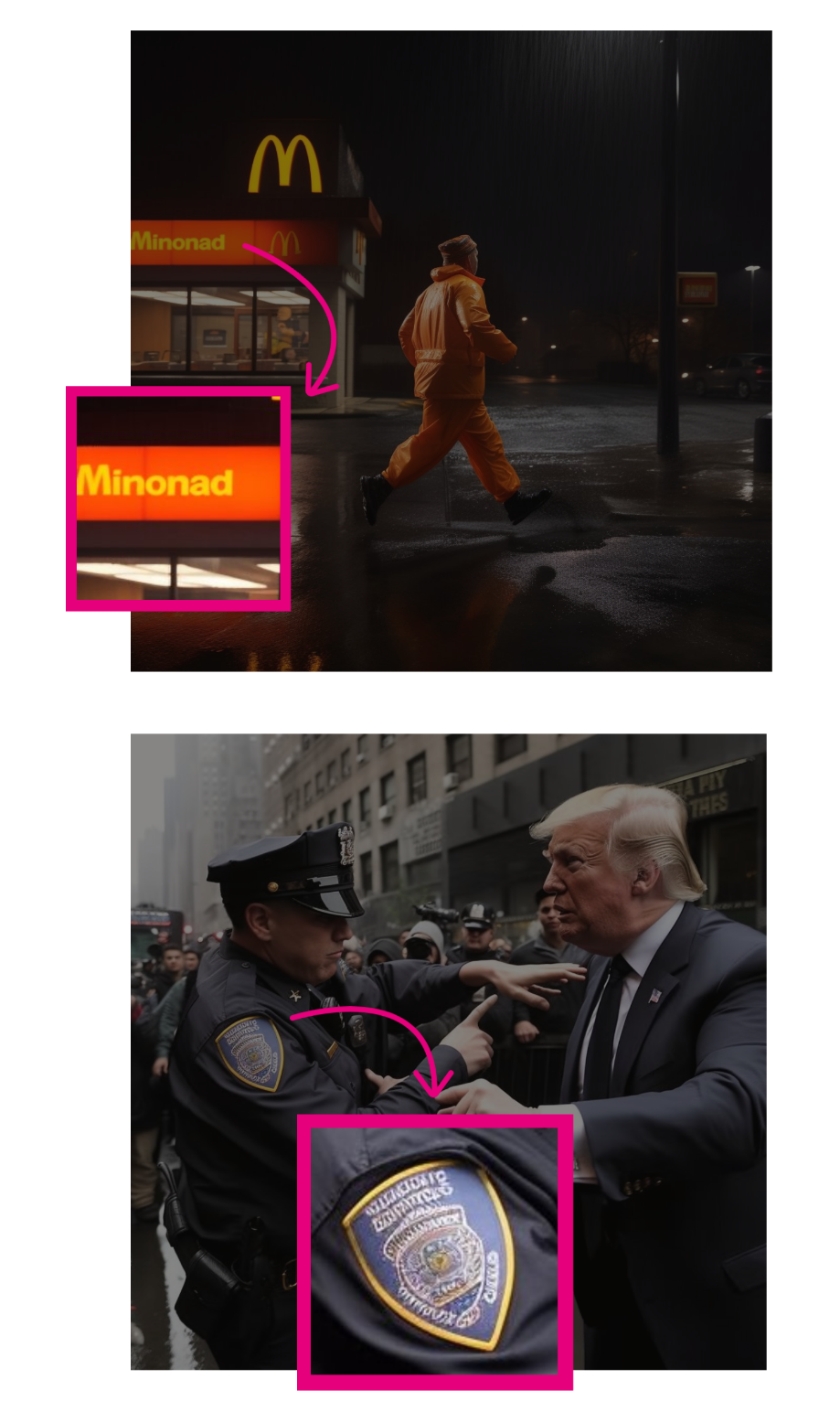

Første gang de dramatiske billeder af Donald Trump i karambolage med politiet florerer på internettet, er det på Twitter

Tilbage i marts begyndte dramatiske billeder af Donald Trump i karambolage med politiet at florere på Twitter. Dengang skrev stifteren af mediet Bellingcat, Eliot Higgings, tydeligt, at billedet er lavet af AI: “Laver billeder af Trump, der bliver anholdt, imens jeg venter på Trumps anholdelse”.

Det viser en omvendt billedsøgning.

Omvendte billedsøgninger kan også bruges til at afsløre falske videoer og billeder, der ikke er lavet af AI. Det og mange flere værktøjer til faktatjek af billeder og videoer kan du blive klogere på i denne guide.

Zoom ind

Hvis du støder på et billede, som virker lidt mistænkeligt eller for vildt til at være sandt, så kan det som det allerførste også være en god idé at bruge zoom-funktionen.

For selvom billeder ved første øjekast ser ægte ud, kan noget så simpelt som et zoom afsløre, at noget er galt. For når først detaljerne er tættere på, er det pludselig nemmere at få øje på ting, der stikker ud.

Plasticagtig hud, unaturligt glatte overflader og andre mærkelige teksturer kan give en fornemmelse af, at billedet er “kunstigt”. Det er værd at huske på, at AI er skabt til at generere perfekte billeder

Med InVIDs verifikationsplugin til Chrome kan man bruge forstørrelsesglas-værktøjet (som findes under ‘image’) til at komme helt tæt på billedets allermindste detaljer, som nogle gange kan være det, der afslører AI’en.

Jo højere opløsning, jo nemmere vil det være at få øje på, at billedet er lavet af AI.

Led efter visuelle spor

Selv uden at gå helt ned i den mindste detalje med zoom-funktionen er det nogle gange til at få øje på, at et billede er AI-genereret ved at kigge efter visuelle tegn, fejl og mangler.

Helt åbenlyst er det vandmærke, som nogle AI-værktøjer automatisk pådutter billeder. For eksempel generer DALL-E en farverig linje nederst i højre hjørne på dens billeder.

Men det er nu engang barnemad at fjerne vandmærket ved blot at beskære billedet, og udvikleren bag DALL-E tillader, at vandmærket fjernes, så længe man “ikke vildleder om involvering af AI”.

Der er til gengæld andre tegn på, at billeder er lavet af AI, som du kan holde øje med.

Plasticagtig hud, unaturligt glatte overflader og andre mærkelige teksturer kan give en fornemmelse af, at billedet er “kunstigt”. Det er værd at huske på, at AI er skabt til at generere perfekte billeder.

Der kan også være en urealistisk detaljegrad og usædvanligt stærke farver i billeder, der er skabt af AI.

Mennesker er svære

Menneskekroppen er kompleks. Den kan være svær for AI at genskabe, og der er en række fejl, som den typisk begår, når den skal generere billeder af mennesker.

For der er åbenbart nogle dele af kroppen, som er sværere at gengive realistisk end andre. Det gælder vores hænder, ører og tænder. For eksempel er de fem fingre, som langt de fleste jo har, ofte suppleret af en ekstra sjette finger. Eller en syvende, ottende og niende.

Forklaringen bag de ekstra fingre ligger i måden, AI’en lærer at lave billeder på. Den bruger nemlig et datasæt bestående af billeder til at forstå, hvordan menneskekroppen ser ud.

Og på langt de færreste billeder er alle fem fingre synlige på samme tid, for eksempel fordi hænderne er foldede eller gestikulerer. Derfor er det svært for AI’en at regne ud, hvordan vores hænder i virkeligheden ser ud.

Også kroppens proportioner kan være svære – og med til at afsløre, at billedet er lavet af AI. Man kan med fordel sammenligne de forskellige mennesker, der optræder på samme billede, for at se om deres proportioner giver mening i forhold til hinanden.

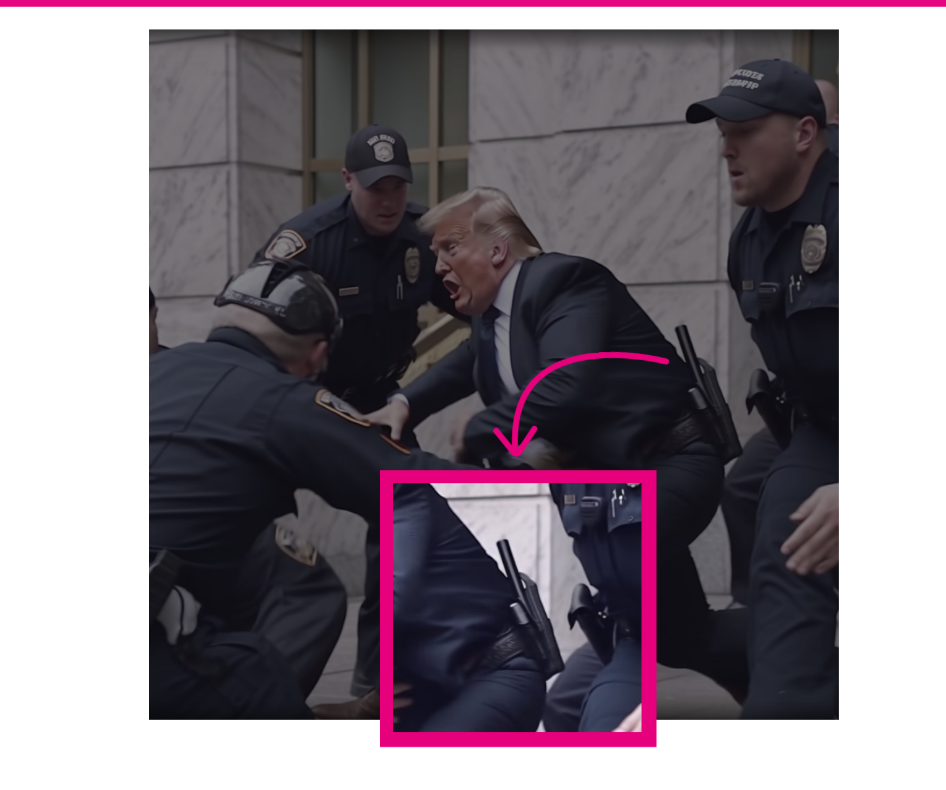

På billederne af Trumps anholdelse, som er lavet af Eliot Higgins, begår AI’en flere fejl i forsøget på at gengive menneskekroppe. En betjent har kun fire, og Trumps ører bliver konsekvent kappet over af hans karakteristiske frisure.

Noget tyder dog på, at man inden længe får svært ved at gennemskue AI-billeder blot ved at tælle fingre på personerne i billedet. For efter en softwareopdatering i marts rapporterede brugere, at Midjourney nu i langt højere grad er i stand til at generere billeder af hænder, der ser realistiske ud.

Tjek baggrunden

Også billeders baggrunde kan i sidste ende være det, der afslører, at de er lavet med AI.

Derfor er det også en god idé at lede efter tekst i billedets baggrund. Hold øje med vejskilte, butiksfacader og personers påklædning. AI-værktøjer har nemlig stadig ikke løst udfordringen med at producere tekst, der ikke er ren volapyk.

Bid også mærke i, om teksten er på det sprog, som det burde være der, hvor billedet påstås at være fra.

McDonald’s er blevet til Minonad, og politiets skilte er fuldkommen ulæselige i Eliot Higgins billeder lavet i Midjourney.

Hvis baggrunden er meget detaljeret, kan det også give pote at gå på jagt i dens figurer og objekter med zoom-funktionen.

AI’en kan for eksempel finde på at klone mennesker og objekter for at bruge dem flere gange i samme billede. Og personers ansigter bliver mere og mere obskure, jo længere væk de er i billedet.

Objekter kan blive forvrængede, få forkerte proportioner og være ude af kontekst for resten af billedet.

Ansigter fjernt i baggrunden er slørede og mangler øjne, en bil og en person er fuldstændig misformede og en vandflaske usandsynligt lille i de AI-genererede billeder.

AI-værktøjer kan også finde på at sløre baggrunden, når de efterligner fotografier. Selve sløringen kan også være med til at afsløre AI.

For når professionelle fotografer gør brug af kamerafokus (altså når hovedmotivet eller personen på billedet fremstår skarp, imens billedets baggrund er sløret), ser det anderledes ud end den kunstige sløring på AI-billeder.

Brug din sunde fornuft

AI-billedteknologi er i rivende udvikling og bliver kun bedre til at minimere de fejl, der gør den relativt nem at få øje på. Men selvom et genereret billede ikke nødvendigvis har åbenlyse fejl som mærkelige proportioner og ekstra fingre, kan din sunde fornuft afsløre det.

Tænk over, om billedet giver mening rent logisk. Kigger personerne i en retning, der giver mening, i forhold til hvad der sker på billedet? Stemmer refleksioner og skygger i billedet overens med, hvor lyset kommer fra?

På ét af billederne af Donald Trumps fiktive anholdelse har han pludselig fået et politibælte på. I forhold til billedets fortælling giver det ikke mening, at Donald Trump bærer bæltet.

Du kan også lave din egen research. Det kan være værd at bruge tid på Google-søgninger efter pålidelige kilder, der kan bekræfte, at en begivenhed faktisk har fundet sted.

For eksempel blev Donald Trump jo faktisk anholdt, men i ro og mag i en retsbygning i New York. Derfor findes der ingen billeder af selve anholdelsen, som desuden foregik, uden ekspræsidenten blev lagt i håndjern.

Overvej også, hvem afsenderen af billedet er. Hvad er deres baggrund, og hvilke motiver kan de have for at dele det?

Forhold dig ekstra kritisk, hvis billedet er politisk, og/eller du har en stærk holdning til det.

Denne artikel er oprindelig bragt hos TjekDet og bringes her efter aftale med TjekDet. TjekDet er et uafhængigt dansk faktatjekmedie, der korrigerer og nuancerer påstande i den offentlige debat.

POV Overblik

Støt POV’s arbejde som uafhængigt medie og modtag POV Overblik samt dagens udvalgte tophistorier alle hverdage, direkte i din postkasse.

- Et kritisk nyhedsoverblik fra ind- og udland

- Indsigt baseret på selvstændig research

- Dagens tophistorier fra POV International

- I din indbakke alle hverdage kl. 12.00

- Betal med MobilePay

For kun 25, 50 eller 100 kr. om måneden giver du POV International mulighed for at bringe uafhængig kvalitetsjournalistik.

![]()

Tilmed dig her ![]()