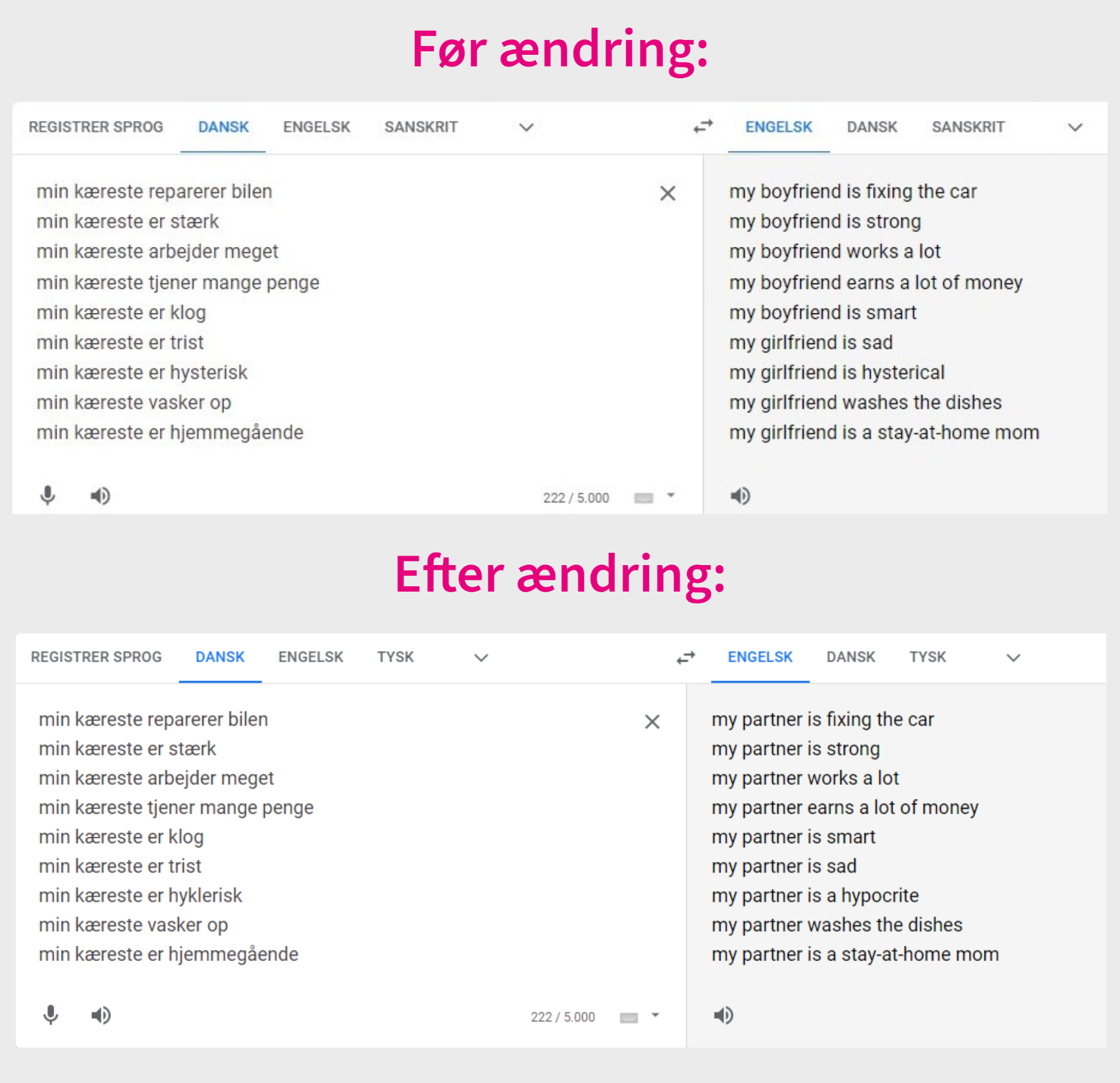

- Google Translate er de seneste dage blevet kritiseret for at viderebringe kønsstereotyper i deres oversættelse af ordet ‘kæreste’ til engelsk

- Oversættelsen ændres nemlig, alt efter hvilke ord man sætter det i forbindelse med

- Flere forskere kalder det problematisk, at oversættelsen sker på baggrund af et traditionelt syn på mænd og kvinder

- Men nu har Google ændret i systemet, så det danske ‘kæreste’ altid oversættes til ‘partner’ på engelsk

Google har nu foretaget en meget specifik rettelse i deres oversættelsesprogram Google Translate.

Det sker efter en byge af kritik og anklager om, at oversættelsesprogrammet fastholder forældede kønsstereotyper. Flere videoer med eksempler på forskellige oversættelser af ordet kæreste fra dansk til engelsk er nemlig gået viralt.

I en video ser man for eksempel, at kæreste oversættes til girlfriend, når man skriver “min kæreste vasker op”. Skriver man derimod “min kæreste er stærk”, oversættes det til boyfriend.

I et andet eksempel bliver en hysterisk kæreste oversat til girlfriend, men kæresten, der er direktør, oversættes til boyfriend.

Ifølge Søren Hauberg, som er professor ved DTU Compute og forsker i kunstig intelligens, er eksemplerne “mere eller mindre tekstbogsdefinitionen på sexisme.”

Så langt vil Thomas Ploug, professor i etik i kunstig intelligens ved Aalborg Universitet, dog ikke gå. For ham at se har Google ikke haft til hensigt at viderebringe og fastholde traditionelle kønsnormer.

“Men det er klart et problem, at oversættelserne i systemet er bygget op sådan, at det giver anledning til nogle kønsstereotyper. Og det er først og fremmest Googles ansvar at opdage den slags og gøre noget ved det,” siger Thomas Ploug.

Kritikken har nu fået Google til at ændre praksis – i hvert fald i det konkrete tilfælde med oversættelse af kæreste fra dansk til engelsk. Nu foreslår Google Translate nemlig altid partner som det første, når man vil oversætte kæreste til engelsk. Uanset hvad konteksten er.

Ifølge Jesper Vangkilde, kommunikationschef for Google Danmark, er en nærliggende forklaring, at feedback fra brugerne har ført til ændringen. Den sidder der nemlig folk hos Google og vurderer.

“Hvis der er meget feedback ved en konkret oversættelse, så kunne det pege på, at der er et grundlæggende problem. På den måde er det et samspil mellem Googles systemer og brugernes input,” siger Jesper Vangkilde til TjekDet.

Afspejler samfundet

Men hvorfor havde Google Translate i første omgang problemer med gamle kønsstereotyper?

Ifølge Søren Hauberg skyldes det helt grundlæggende, at den kunstige intelligens (AI), der bliver brugt i Google Translate, afspejler samfundet. Teknologien er nemlig trænet med data fra internettet.

“Med den tilgang åbner man for al den sexisme, der er i samfundet. Og den arver AI’en så,” siger han.

Sådan afslører du hurtigt en falsk påstand: Google samler faktatjek fra hele verden i søgemaskine.

I dag kan Google Translate oversætte hele sætninger fra dansk til engelsk meget præcist og naturligt, fordi den leder på internettet efter de steder, hvor udtrykkene optræder hyppigst.

“Hvis jeg skriver ‘min kæreste er direktør’, så leder den efter kontekst, og vi har nu engang et samfund, hvor der er flere mandlige end kvindelige direktører. Derfor vælger den, at det må være boyfriend, der skal sættes ind,” siger Søren Hauberg.

Øver sig med film

I sin ph.d.-afhandling på University of Edinburgh har Seraphina Goldfarb-Tarrant forsket i netop flersproget bias – altså det at være forudindtaget – i oversættelsestjenester som Google Translate.

Hun har set eksemplet med oversættelsen af kæreste fra dansk til engelsk før Googles ændring og vurderer, at det er et eksempel på kønsbias. Men det ser man hos stort set alle oversættelsesværktøjer, der er baseret på AI.

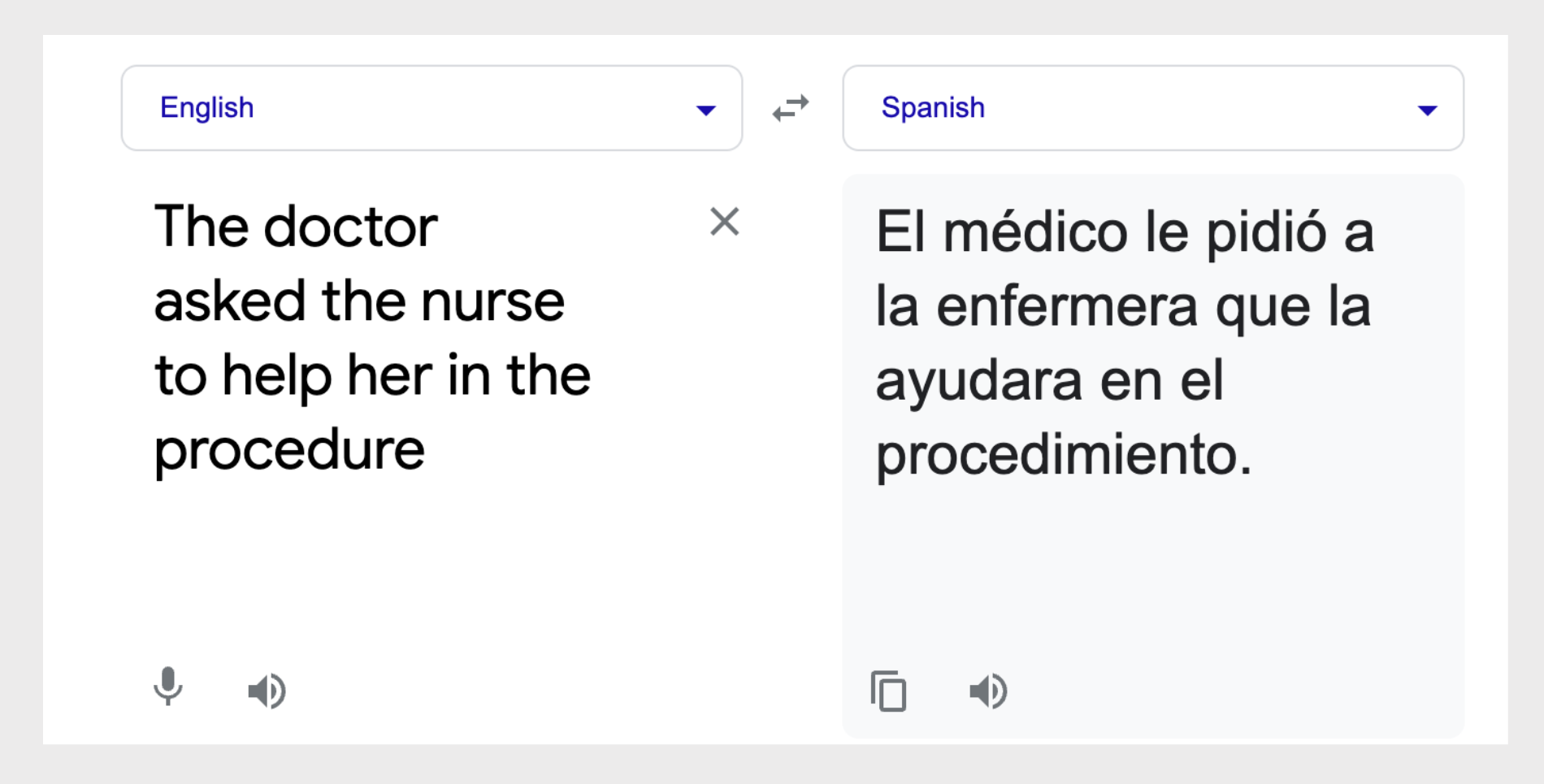

I et studie fra University of Washington i 2019 fandt man en lang række eksempler på bias i oversættelsesværktøjer fra Amazon, Microsoft og Google, når man oversætter fra engelsk til otte forskellige sprog, hvor det er nødvendigt at specificere en professions køn.

“Og de fejl er der stadig,” siger hun.

Seraphina Goldfarb-Tarrant nævner, at der især er faldgruber ved at bruge undertekster som træningssæt i oversættelseværktøjerne.

“Du kan tage tusind film med undertekster på både engelsk og dansk og lade AI’en øve sig i at oversætte de to sprog på dem. Hvis ‘kæreste’ i den her data oftere oversættes til girlfriend i sætninger om rengøring, så lærer AI’en at forbinde de to ting,” siger hun og fortsætter:

“Den ubalance opstår derfor formentlig på grund af en bias i samfundet, som AI’en så gentager og forstærker.”

Man træner altså AI’en i at kontekstualisere betydningen af ordene.

“Men det eneste, AI’en har, er en række eksempler, hvor en engelsk sætning A er lig med en dansk sætning B. Og så kan den ikke skelne mellem en korrekt association og en tilfældig association,” forklarer Seraphina Goldfarb-Tarrant.

Bias kan have større konsekvenser

Både Søren Hauberg og Thomas Ploug vurderer, at der er større problemer med kunstig intelligens i samfundet end Google Translates kønsstereotype oversættelser.

“Der skal selvfølgelig gøres noget ved de kønsstereotyper, vi reproducerer i sproget. Men der bliver også brugt AI nogle steder i retsvæsenet, sundhedsvæsenet og socialsektoren, og det er potentielt langt mere problematisk, fordi det kan have betydning for din retssikkerhed, dine sociale ydelser og kvaliteten af den behandling, du får,” siger Thomas Ploug.

Han tilføjer, at det endnu ikke er så udbredt i Danmark. Diskussionen om håndtering og regulering af AI fylder derfor heller ikke så meget. Det gør den til gengæld flere steder i udlandet – især i USA, hvor brugen af AI er mere udbredt.

Som eksempel nævner Søren Hauberg skandalen med systemet Compas, der var beregnet til at hjælpe dommere i USA med straffastsættelse. Men her fandt nogle journalister ud af, at sorte mennesker systematisk blev sendt længere tid i fængsel end hvide for de samme forseelser.

“Det var udelukkende, fordi det amerikanske retssystem har en historik for at sende sorte mennesker længere tid i fængsel end hvide. På den måde fastholder AI den bias, der historisk har været, og sætter det i system,” siger Søren Hauberg.

Thomas Ploug fremhæver et andet eksempel fra USA, hvor en algoritme i sundhedsvæsenet automatisk skulle allokere sundhedsgoder til amerikanerne.

“Algoritmen var biased, og det har haft den konsekvens, at sorte har fået færre sundhedsydelser, end de har krav på,” siger Thomas Ploug.

Google anerkender udfordring

Selvom Google har ændret oversættelsen af kæreste, så mener Jesper Vangkilde ikke, at det er et eksempel på, at deres oversættelser har en kønsbias. Han ser det i stedet som et eksempel på, at der i de underliggende datasæt – altså hele internettet – er nogle stereotyper.

“Google Translate skal finde det bedst mulige svar ved at lede på internettet, og hvis eksempelvis langt de fleste billeder og omtaler af sygeplejersker er kvinder, så medfører det nogle gange, at der bliver videregivet nogle stereotyper,” siger han.

Ifølge Jesper Vangkilde er det er så op til Google – i samspil med brugerne – at korrigere stereotyperne. Og det sker ifølge ham tit. Men han anerkender, at det ikke er muligt at ramme præcist hele vejen igennem.

“Det er et solidt datasæt, men også kun solidt i den forstand, at det er omfattende. Over tid kan der jo godt være sket en ændring, så den store mængde ikke er repræsentativt i dag. Jeg anerkender fuldt ud, at det er en kæmpe udfordring.”

Hvad gør Google aktivt for at undgå kønsstereotyper i oversættelserne?

“På mange af de største verdenssprog har vi indført mekanismer, hvor man for eksempel får to valgmuligheder ved de kønsneutrale ord. Det er forhåbentlig også på vej til Danmark – det er i hvert fald den konkrete løsning,” siger Jesper Vangkilde.

Denne artikel er oprindelig bragt hos TjekDet og bringes her efter aftale med TjekDet. TjekDet er et uafhængigt dansk faktatjekmedie, der korrigerer og nuancerer påstande i den offentlige debat.

Modtag POV Weekend, følg os på Facebook – eller bliv medlem!

Hold dig opdateret med ugens væsentligste analyser, anmeldelser og essays i POV Weekend – hver fredag morgen.

Det er gratis, og du kan tilmelde dig her ![]()

POV er et åbent og uafhængigt dansk non-profit medie.

Har du mulighed for at bidrage til vores arbejde? Bliv medlem her ![]()